«Die totale Forschungsfreiheit ist eine Illusion»

Forschende bewegen sich im Spannungsfeld zwischen Freiheit und Verantwortung. Digitalisierung und Künstliche Intelligenz sorgen für neue Brisanz. Dass Hochschulen ethische Dimensionen und die Folgen ihrer Forschung mitdenken sollen, darüber sprechen Karin Nordström, Präsidentin des ZHAW-Ethikausschusses, und Christoph Heitz, ZHAW-Experte für faire Algorithmen im Interview.

Die akademische Freiheit ist ein Grundrecht und in der Bundesverfassung der Schweiz verankert. Weshalb ist freie Forschung wichtig?

Karin Nordström: Menschen sind grundsätzlich neugierig und wissbegierig. Das sind Eigenschaften, die sehr viel Gutes hervorgebracht haben für die Gesellschaft. Da will der Gesetzgeber möglichst wenig eingreifen, um der Kreativität möglichst freien Lauf zu lassen.

Christoph Heitz: Dieser Artikel bezieht sich auch darauf, dass sich Forschende nicht instrumentalisieren lassen sollen zum Beispiel von wirtschaftlicher oder politischer Macht – zumindest nicht undeklariert.

Den einen geht die Forschungsfreiheit zu weit. Andere sehen sie in Gefahr.

Nordström: Die totale Forschungsfreiheit ist eine Illusion. Was Forschende interessiert, welche Fragen gestellt werden, ist Teil ihrer Sozialisierung in gewissen gesellschaftlichen, wirtschaftlichen oder politischen Kontexten oder richtet sich nach Forschungstraditionen. Im besten Fall machen Forschende die Fragen anderer zu ihren Fragen – das muss nicht im Widerspruch zur Freiheit stehen. Im schlimmsten Fall stellen und beantworten sie nur ihre eigenen Fragen – das ist dann Forschung im Elfenbeinturm.

«Was Forschende interessiert, welche Fragen gestellt werden, ist Teil ihrer Sozialisierung in gewissen gesellschaftlichen, wirtschaftlichen oder politischen Kontexten oder richtet sich nach Forschungstraditionen.»

Wie frei ist die angewandte Forschung?

Heitz: Als anwendungsorientierte Hochschule forschen wir in der Regel in Kooperation mit Partnerfirmen oder Institutionen. Deshalb ist es wichtig, vor Beginn der Zusammenarbeit die Ziele auszuhandeln. Die Projekte müssen so ausgestaltet sein, dass sie mit den Wertvorstellungen der Wissensarbeitenden vereinbar sind – durchaus unter Anerkennung der Rahmenbedingungen.

Ist das nicht ein Widerspruch?

Heitz: Nicht per se. Wir sind keine Erfüllungsgehilfen. Da wir aber nicht nur Wissen generieren, sondern mitwirken, es direkt in die Praxis umzusetzen, ändern wir ganz konkret den Lauf der Dinge. Wir haben als Fachhochschulen faktisch den Auftrag, die Welt zum Besseren zu verändern. Das ist ein vornehmer Auftrag. Wir müssen uns aber die Frage stellen, wodurch dieser Auftrag konterkariert werden könnte.

«Da wir nicht nur Wissen generieren, sondern mitwirken, es direkt in die Praxis umzusetzen, ändern wir ganz konkret den Lauf der Dinge. Wir haben faktisch den Auftrag, die Welt zum Besseren zu verändern.»

Wie lautet die Antwort?

Heitz: Zum Beispiel durch Machtstrukturen oder ungewisse Finanzierungsmöglichkeiten. Es ist also ein grosser Anspruch, unsere Unabhängigkeit als Forschungsinstitution zu wahren – die für unsere Akzeptanz zentral ist. Mindestens ebenso wichtig wie Unabhängigkeit ist ein anderer Aspekt: Wir haben die Verantwortung für das, was wir tun. Die Entschuldigung der Grundlagenforschung, dass sie ja nur Wissen generiert, während die Anwenderinnen und Anwender letztlich dafür verantwortlich seien, was damit geschieht – diese gilt für uns nicht in der gleichen Weise. Bei allen unseren Projekten müssen wir die Frage mitdenken: Was passiert mit unserer Welt, wenn unsere Forschungsergebnisse in die «freie Wildbahn» entlassen werden.

Gibt es Grenzen der Forschung?

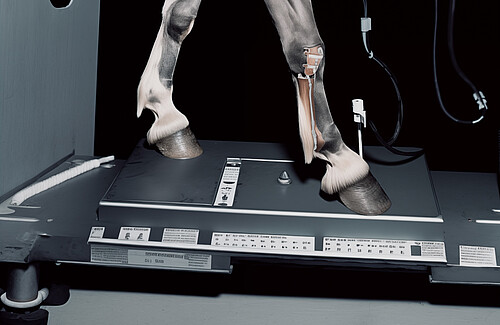

Nordström: Die Einstellung, alles wissen zu wollen, ist per se gut und wichtig. Der Zweck darf aber nicht die Mittel heiligen. Die Methoden zur Durchführung von Forschung müssen ethisch vertretbar sein: Das heisst, der zu erwartende Nutzen eines Forschungsvorhabens muss in einem angemessenen Verhältnis zu potenziellen Risiken stehen. Nicht alles, was möglich ist, ist unbedingt erstrebenswert. Wir sollten uns stets fragen: Wozu brauchen wir das Wissen, wozu verwenden wir es, wohin wollen wir? Welche Art von Erkenntnissen bringt uns weiter oder trägt zu einer nachhaltigen, fairen Lebenswelt bei? Solche Fragen müssen im Gesundheitsbereich, in dem ich arbeite, vor allem in der Genforschung gestellt werden.

«Wir müssen uns fragen: Welche Art von Erkenntnissen bringt uns weiter oder trägt zu einer nachhaltigen, fairen Lebenswelt bei?»

Heitz: Uns als Hochschule stünde es gut an, an die Dinge zu denken, die über den Business Case unserer Firmenpartner hinausgehen. Das ist für mich zentral. Denn die Interessen der Partnerunternehmen sind zunächst einmal anders gelagert: Wer auf wirtschaftlichen Erfolg und Geldverdienen abzielt, denkt nicht in erster Linie an z.B. soziale Auswirkungen. Besonders im Gebiet der KI, in dem ich arbeite, ist das aber eines der zentralen Probleme.

Werden Warnungen der Forschenden berücksichtigt?

Heitz: Meine Erfahrung ist: Wenn wir die Risiken und unsere Überlegungen auf den Tisch bringen, dann werden wir ernst genommen. Unsere konstruktive Aufgabe besteht darin, Lösungen zu entwickeln, die unsere Partnerunternehmungen weiterbringen, gleichzeitig aber auch verträglich sind mit den Werten unserer Gesellschaft. Nicht immer einfach, aber einfach immer lohnend. Damit schaffen wir soziale Nachhaltigkeit, die auch im Interesse unserer Partner ist.

An der ZHAW gibt es seit einem Jahr einen Ethikausschuss: Wozu braucht es diesen?

Nordström: Es gibt einen Graubereich bei der Forschung am oder mit Menschen. Nicht alle Projekte fallen unter das Humanforschungsgesetz und müssen folglich auch nicht von einer Kantonalen Ethikkommission geprüft werden. Dennoch werfen sie ethische Fragen auf. Hochschulen haben deshalb interne Kommissionen oder Ausschüsse dafür eingerichtet. Kommt hinzu, dass einige wissenschaftliche Zeitschriften zur Bedingung gemacht haben, dass die Methoden und Resultate aus ethischer Sicht geprüft wurden, bevor sie diese veröffentlichen. Auch beim Schweizerischen Nationalfonds ist Voraussetzung dafür, dass Fördermittel gesprochen werden, dass diese Vorhaben ethischen Kriterien standhalten können.

Welches ist das oberste «Gebot» des ZHAW-Ethikausschusses?

Nordström: Es muss eine Balance zwischen Nutzen und Risiken geben. Der Fokus liegt auf dem Schutz der Studienteilnehmenden: Wurden sie ausreichend und verständlich darüber informiert, worum es geht? Konnten sie auf dieser Basis eine informierte Zustimmung geben? Wurde dieses Einverständnis eingeholt und dokumentiert? Auch Fragen zur Datensicherheit müssen gestellt werden.

«Wir müssen stets die Frage mitdenken: Was passiert mit unserer Welt, wenn unsere Forschungsergebnisse in die ‘freie Wildbahn’ entlassen werden?»

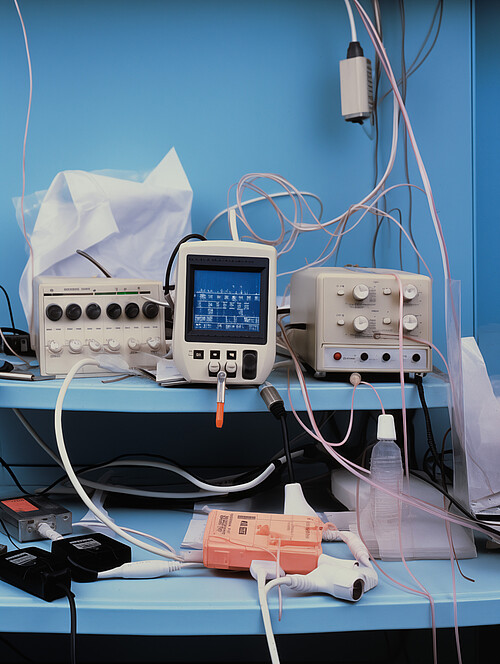

Heitz: Datenschutz war das grosse Thema im Kontext der Digitalisierung in den Jahren 2000 bis 2015. Mit Künstlicher Intelligenz befindet sich unsere Gesellschaft in einer neuen Phase. In grossem Stil wir jetzt darüber diskutiert, wie man mit KI die Welt verändert und welche ethischen Fragen dabei geklärt werden müssen.

Sind KI und die Auswirkungen auf den Menschen Thema im ZHAW-Ethikausschuss?

Nordström: Bisher nicht. Das ist Neuland und brächte eine ganz andere Dimension in die Arbeit mit ein.

Heitz: Im Grunde hat aber ein grosser Teil unserer Forschung hinsichtlich Digitalisierung ganz direkte Auswirkungen auf Menschen, schon allein, wenn man bedenkt, welche Auswirkungen Apps auf unseren Alltag haben. Wir leben in einer Welt, die durchdrungen ist von ganz vielen Systemen im Hintergrund. Ich würde nicht so weit gehen, zu sagen, dass sie uns manipulieren, aber doch irgendwie steuern. Die EU ist gerade dabei, mit dem AI Act einen weltweit einzigartigen Rechtsrahmen für Künstliche Intelligenz zu setzen.

Was regelt der AI Act der EU?

Heitz: Dieses Gesetz basiert auf einem Risikoansatz. KI-Systeme werden nach dem Risiko, das sie für die Menschen darstellen, analysiert und klassifiziert: Wie gross ist das Risiko, dass jemand zu Schaden kommt? Oder werden Bevölkerungsgruppen systematisch diskriminiert und ins wirtschaftliche Abseits gestellt, weil ein Algorithmus so funktioniert, dass Menschen dieser Gruppen systematisch schlechter gestellt werden, wenn es um Stellen, Kredite oder Versicherungen geht? Das passiert häufig und basiert in der Regel nicht auf einem Programmierfehler, sondern auf der Logik der Aufgabenstellung, die solche gesellschaftlichen Auswirkungen nicht mitberücksichtigt. Ist die Auswirkung von KI-Systemen auf das Leben von Menschen gross, setzt die Regulierung ein. Dies gilt etwa für Systeme im Gesundheitswesen, aber auch bei wichtigen Dienstleistungen wie Banken oder Versicherungen.

Christoph Heitz, Schwerpunktleitung Smart Services and Maintenance der School of Engineering und Präsident der Data Innovation Alliance. Karin Nordström, Präsidentin des ZHAW-Ethikausschusses und Studiengangleitung im Bachelor Gesundheitsförderung und Prävention am Departement Gesundheit.

Ist sich die Wirtschaft dieser Risiken bewusst?

Heitz: Ein Weckruf waren 2017 die US-Wahlen, als die Einflussnahme durch die Datenanalysefirma Cambridge Analytica aufgedeckt wurde und Donald Trump an die Macht kam. Ab diesem Zeitpunkt wurde deutlich, dass es nicht mehr nur auf den Datenschutz ankommt. Da wurden völlig neue Dimensionen der Digitalisierung deutlich. In dieser Zeit entstand auch aus einer Initiative der ZHAW das Netzwerk Data Innovation Alliance, dem heute 25 Forschungsinstitutionen und 50 Firmen angehören und dessen Präsident ich bin. Das Netzwerk treibt Innovation mittels Nutzung von Daten voran. Wir standen vor der Frage: Was tun wir da eigentlich und mit welchen Auswirkungen auf die Welt? Wir haben deshalb schon 2017 eine Ethikexpertengruppe aufgesetzt und einen Ethikkodex speziell für den Umgang mit Daten entwickelt. Wir sind überzeugt, dass wir sicherstellen müssen, dass die Nutzung von Daten und KI unsere gesellschaftlichen Werte wie Freiheit, Autonomie oder soziale Gerechtigkeit nicht beschädigt. Langfristig ist diese Art von sozialer Nachhaltigkeit für die ganze Branche von zentraler Wichtigkeit, also im direkten Interesse der Firmen.

Was tut die ZHAW für mehr Fairness und soziale Gerechtigkeit bei Algorithmen?

Heitz: Bisher war unser Verständnis in den Ingenieurwissenschaften und der Informatik derart, dass wir in erster Linie technische Fragen lösten. Das reicht heute nicht mehr. Ich glaube, speziell im Rahmen der Digitalisierung haben wir als anwendungsorientierte Hochschule eine wirklich grosse Aufgabe und Verantwortung, unsere Projekte inhaltlich so auszurichten, dass sie kompatibel sind mit den Werten unserer Gesellschaft. Wenn man eine Applikation entwickelt, dann muss man sich entscheiden, welche Wertvorstellungen mit den technologischen Lösungen verbunden sein sollen. Um Fachleute darin auszubilden, bieten wir seit dem Frühlingssemester 2023 ein Modul für Informatik- und Data-Science-Studierende zum Thema Algorithmic Fairness an und ab Frühjahr 2024 auch in der Weiterbildung. Die ZHAW ist damit eine der ersten Hochschulen in der Schweiz, die so etwas im Grundstudium implementiert.

Wie ist Fairness in diesem Unterrichtsmodul definiert?

Heitz: Es ist Teil des Unterrichts, zu zeigen, dass es unterschiedliche Definitionen von Fairness gibt und dass man nicht in jeder Beziehung fair sein kann. Es muss vielmehr eine normative Festsetzung geben. Diese können aber nicht die Ingenieurinnen und Ingenieure selber vornehmen, sondern da müssen sie das Management ins Boot holen. Die Ingenieure müssen aber die ethischen Fragestellungen und Optionen aufzeigen. Denn nur sie haben ein Gefühl dafür, welche technischen Optionen es gibt und welche ethischen Auswirkungen diese haben. Welche Konsequenzen und Risiken das Unternehmen tragen will, muss letztlich das Management entscheiden.

Nordström: Dann ist es Teil der Ausbildung, zu zeigen, dass Technologie nicht neutral ist, sondern dass da Werte mitspielen?

Heitz: Ja, hier werden die Studierenden sensibilisiert, dass zum Beispiel durch das Design oder die konkrete technische Ausgestaltung von Vorhersage-Algorithmen Tools produziert werden können, die unzulässig diskriminieren. Sie lernen nicht nur, wie man das erkennt und welche Ideen von sozialer Gerechtigkeit mit solchen Modellen verknüpft werden können, sondern auch, wie man Diskriminierung vermeiden und Fairness konkret in einen Algorithmus implementieren kann. Das ist ein Beispiel für die Art von Verantwortung, die wir als anwendungsorientierte Hochschule übernehmen sollten.

Sie setzen auf die Generationen von morgen?

Heitz: Nicht nur. Wir sollten zunächst selbst die Kompetenz für diese umsichtige Weitsicht entwickeln, zweitens die Studierenden hierin ausbilden und nachher draussen bei der Umsetzung die richtigen Fragen stellen, aber auch in der Lage sein, Lösungen für diese Fragen zu entwickeln mit möglichst wenig unliebsamen Auswirkungen.

Was wäre ein Beispiel für so eine Frage?

Heitz: Nehmen wir an, wir brauchen ein Tool zur Unterstützung der Entscheidung für die Verteilung finanzieller Mittel im Gesundheitswesen. Eine typische normative Frage wäre dann: Sollen die medizinischen Ressourcen über alle gleichmässig verteilt werden? Oder will man die Mittel bedarfsgerecht verteilen, etwa um zu erreichen, dass Frauen die gleichen Heilungschancen haben wie Männer? Je nach Wahl sähe die technische Implementierung ganz unterschiedlich aus.

Nordström: Das ist auch die grosse Frage bei Public Health: Wie müssten chancengerechte Gesundheitsversorgung, Gesundheitsförderung und Prävention aussehen? Wo sind Ungleichheiten notwendig, um eine Gleichheit zu erreichen? Habt Ihr Data Scientists auch Lösungen für solche Fragen?

Heitz: In der Forschung sind hier in den letzten Jahren viele Ansätze entwickelt worden – diese gilt es jetzt in die Praxis zu bringen. Die Gefahr ist gross – und das sehen wir bei KI-Applikationen immer wieder –, dass Leute Lösungen bauen, und fünf Jahre später staunen sie: Oh, da ist jetzt was ganz Schlimmes passiert, was man nie beabsichtigt hat. Aber niemand hat daran gedacht, zu Beginn nach den Folgen zu fragen, die normative Setzung zu machen und die Technologie so anzupassen, damit bestimmte Anforderungen erfüllt werden.

Nordström: Das gilt für Forschung generell.

Heitz: So ein vorausschauendes und ethisches Denken muss deshalb trainiert werden

KI ist ein so umfassendes Thema, dass selbst prominente Vertreter von Google oder Elon Musk und Co. einen Forschungsstopp gefordert haben angesichts der Risiken.

Heitz: Forschungsmoratorien halte ich nicht für angebracht. Dann passiert vielleicht nichts Schlimmes mehr, aber auch nichts Gutes. Ich finde, es braucht keine Verbote, sondern eine Verpflichtung, technische Lösungen so zu gestalten, dass negative Auswirkungen minimiert werden. Das heisst, als Forschende müssen wir auch Lösungen für einen verantwortlichen Einsatz entwickeln. Wir können unsere Forschungspartner befähigen, sensibel zu werden für die Fragen nach den Risiken, und sie gleichzeitig darin unterstützen, die gesellschaftlichen Nebenwirkungen unter Kontrolle zu behalten. Dies ist herausfordernd, aber vor herausfordernden Fragestellungen sollten wir als Hochschule keine Angst haben.

Glossar

AI Act:

Das Gesetz über Künstliche Intelligenz (KI) der EU (AI Act) ist das weltweit erste Gesetz, das KI regulieren will. Es basiert auf einer Risiko-Klassifizierung und hat sichere, transparente, nachvollziehbare, nicht diskriminierende und umweltfreundliche KI-Systeme zum Ziel.

Kantonale Ethikkommission (KEK)

Die KEK prüft Forschungsprojekte mit Menschen, deren Gesundheitsdaten und Proben, wenn es um neue Erkenntnisse zu körperlichen und psychischen Krankheiten oder um den Aufbau und die Funktion des menschlichen Körpers geht.

Algorithmus

Ein Algorithmus ist eine eindeutige Handlungsvorschrift zur Lösung eines Problems oder einer Klasse von Problemen.

Austausch und Reflexion über Ethik

Um den Austausch zu ethischen Fragen zu intensivieren, startete die ZHAW die offene Diskussionsreihe «ZHAWARE». Das Projekt hat zum Ziel, eine Plattform aufzubauen, die die Reflexion und den Austausch fördert, nicht nur unter den Mitarbeitenden und Studierenden an der Hochschule, sondern auch mit Partnern in Gesellschaft und Wirtschaft. Ausgangspunkt war eine Umfrage bei allen Studierenden und Mitarbeitenden. Aus 78 Ideen wurden fünf Themen für einen ersten Veranstaltungszyklus ausgewählt: Es ging um «kritisches Denken», «ethische Verantwortung in der Forschung», «Wokeness und Wissenschaftsfreiheit», «extreme Gesinnungen und die Grenzen der Freiheit» sowie um die Frage, ob ethisches Handeln eine individuelle oder institutionelle Verantwortung ist.

0 Kommentare

Sei der Erste der kommentiert!